あらゆる規模や業種の組織が、人間には理解できないほど膨大な量のデータにアクセスできるようになりました。。2023年現在までに、世界は1日あたり3億2,877万テラバイトという、ほとんど想像を絶する数のデータを生み出し、消費しています。しかし、これらの情報を効率的に処理と分析し、ノイズの中に隠された貴重なデータ主導の洞察を明らかにする方法がなければ、これらすべての情報は役に立ちません。

ここでは、ETLツールについて知っておくべきことを4つご紹介します:

- ETLは、ソースからデータを抽出し、分析に適した形式に変換し、データウェアハウスのような一元化された場所にデータをロードするデータ統合手法です。

- 手作業でETLを行うには、データエンジニアが複雑なデータパイプラインを構築する必要があります。

- ETLツールはこのプロセスを合理化し、御社のような企業がデータ抽出、スキーマ、取り込み、API、その他の複雑な要素を心配することなく、異なるロケーション間でデータを移動できるようにします。

- すべてのETLツールが同じというわけではありません。このリストでは、特徴、機能、ユーザーレビューのスコアに基づいて、最高の製品を紹介しています。

ビッグデータの日常業務を管理し、複数の部門にまたがるチームのためにより良い洞察を得るために、主要なデータ統合ツールを検討してください。技術的な知識や能力が高い人向けのオプションもあれば、コード不要のシンプルなソリューションを求める人向けのオプションもあります。ETLは、より優れたセキュリティと機能を備えた、より簡単なデータ移動方法です。

目次

- ETLとは

- ETLツールとは

- ETLツールの書類

- ETLツール評価方法

- 検討すべきETLツールトップ7つ

- その他

- トップ ETL ツールのユースケース

- Integrate.io が ETL にできること

ETL とは

ETLとは、抽出(Extract)、変換(Transform)、格納(Load)の略であり、複数のソースからデータを収集し、単一のデータセットに統合するデータ統合プロセスです。ETLは、様々なソースからデータを集め、データウェアハウスのような一元化されたターゲットシステムに格納する最も一般的な方法であり、通常、手作業によるデータパイプラインの構築と複雑なコーディングを必要とし、場合によっては導入に数週間から数ヶ月かかることがありますが、ETLツールはこのプロセスを自動化し、それによってデータエンジニアリングの経験がなくても、あらゆる規模の組織でデータを拠点間で移動させることができるようになります。

- 抽出: 元のソースからデータを抽出する。

- 変換: 抽出されたデータは、重複排除、結合、品質チェックなどの変換を受け、正確性と一貫性が確保される。

- ロード:変換されたデータは、データウェアハウスなどのターゲットデータベースにロードされる。

かつて、ETLプロセスは、手間のかかる手作業によるパイプライン構築と複雑なコーディングを必要とし、実装には数週間から数カ月を要していました。しかし、ETLツールの登場によってプロセスが自動化され、あらゆる規模の組織がデータエンジニアリングの専門知識がなくても効率的にデータを拠点間で移動できるようになりました。

ETLツールの導入は、データ管理の合理化、データ分析の強化、意思決定能力の向上など、いくつかのメリットをもたらします。ETLツールを活用することで、企業はデータパイプラインを最適化し、データフローを追跡し、より迅速な洞察を促進することができます。

ここでは、優れたETLツールの特徴と、要件に合ったツールの見つけ方について説明します。

ETL ツールとは

ETLツールは、複数のソースからのデータの抽出や適切な形式への変換、さらに処理されたデータのターゲットとなる目的地への格納をしやすくするソフトウェアアプリケーションであり、ETLプロセスによって、企業は様々なソースからデータを迅速かつ正確に集計し、分析や報告をすることができます。

いいETLツールの条件

ETLツールを選択する際には、そのETLがデータ要件の複雑さに確実に対応できるようにしたいものです。よくできた ETLツールというのは、大量のデータを最小限の労力で迅速かつ効率的に移動・変換することができるはずです。また、複数のデータソースをサポートし、異なるシステムからのデータセットを簡単に一元化されたレポジトリにまとめることもできるはずです。さらに、直感的なUX(ユーザーインターフェース)は、データの操作、設定、タスクのスケジューリングを素早く行うための重要な鍵となります。最後に、ETLツールは、シームレスなワークフローのために、技術スタックの他のツールと統合することができる必要があります。

ツールにもよりますが、上記のプロセスのほとんどは完全に効率化されます。事前構築済みのデータコネクタは、ほとんどあるいはまったくコードを書かずに、データを抽出、変換し、ターゲットシステムに格納するため、複雑なデータ抽出、取り込み、APIの管理などの作業が不要になります。

適切な ETL ツールがあれば、企業は精度や拡張性を犠牲にすることなく、分析プロセスを加速させることができます。ETLは、データ駆動型の企業にとって不可欠な要素であり、適切なツールを使用することで、その差は歴然になるのです。

関連記事:ノーコード・プラットフォームのROI

ETLツールの種類

ETLツールに関しては、様々なニーズに合わせて様々な選択肢があります。ここでは、一般的なETLツールの種類をいくつかご紹介します:

オープンソースETLツール

オープンソースのソリューションは、データ統合のための柔軟でカスタマイズ可能なオプションを提供します。これらのツールは幅広い機能を提供し、費用対効果の高いソリューションを求める技術に精通したチームに好まれることが多いです。

クラウドベースのETLツール

クラウドベースのETLツールは、クラウドコンピューティングのパワーを活用し、大規模なデータ統合タスクを処理します。これらのツールは、拡張性、コスト効率、および他のクラウドサービスとの容易な統合を提供します。

エンタープライズグレードのETLツール

エンタープライズグレードのツールは、包括的な機能と堅牢な機能を提供します。これらのツールは、複雑なデータ統合シナリオ向けに設計されており、データガバナンスやメタデータ管理などの高度な機能を提供します。

リアルタイムETLツール

リアルタイムETLツールは、ストリーミングデータ統合に重点を置いています。リアルタイムにデータを処理・統合し、最新かつタイムリーな洞察を得ることができます。

セルフサービスETLツール

セルフサービスETLツールは、ビジネスユーザーがITチームに頼ることなくデータ統合タスクを実行できるようにします。これらのユーザーフレンドリーなツールは、ドラッグ&ドロップのインターフェースを提供し、最小限のコーディング知識しか必要としません。

ETLツールの評価方法

適切なETLツールの選択は、拡張性、データ統合要件の複雑さ、予算などの要因によって異なります。ETLツールを探す際には、ニーズとオプションを評価することが重要です。どのようなデータソースを接続する必要があるのでしょうか?どの程度の自動化が必要か?クラウドとオンプレミスのどちらが良いでしょうか?

これらの質問に対する答えによって、ETLツールにどのような機能を求めるべきかが決まります。

ETLツールを評価する際に考慮すべき主な基準は以下の通りです:

- 使いやすい:直感的な UI(ユーザーインターフェース)を備えているか、それとも複雑なコーディングやスクリプトを必要とするか?一般的なデータソースのためのデータコネクターがあらかじめ用意されているか?

- スケーラビリティ(拡張性):そのツールは大量のデータを扱えるか?どれくらいのスピードでデータを処理できるのか?

- 安全性:安全なデータ転送と機密情報の暗号化が提供されているか?特定のデータを閲覧・修正できる人のアクセスコントロールは可能か?

- ドキュメントとサポート:すぐに使い始められるように、ベンダーは詳細なドキュメント、チュートリアル、その他のリソースを提供しているか?カスタマーサービスやテクニカルサポートは利用できるか?

- 高度な機能:ETLツールは、データ変換、検証、自動ワークフローなどの機能を提供しているか?より複雑なタスクのカスタムコーディングが可能か?

- コスト:ETLツールの導入と使用に必要な総費用はいくらか?また、利用やアップグレードに伴う追加費用はあるか?

検討すべきETLツールトップ7つ

ETLはデータウェアハウスや分析に欠かせないものですが、ETLソフトウェアツールが全て同じように作られているわけではなく、状況やユースケースによって、最適なETLツールは違ってくるかもしれません。ここでは、2023年のオススメETLソフトウェアツール7選と、その他に検討したいツールをいくつかご紹介します:

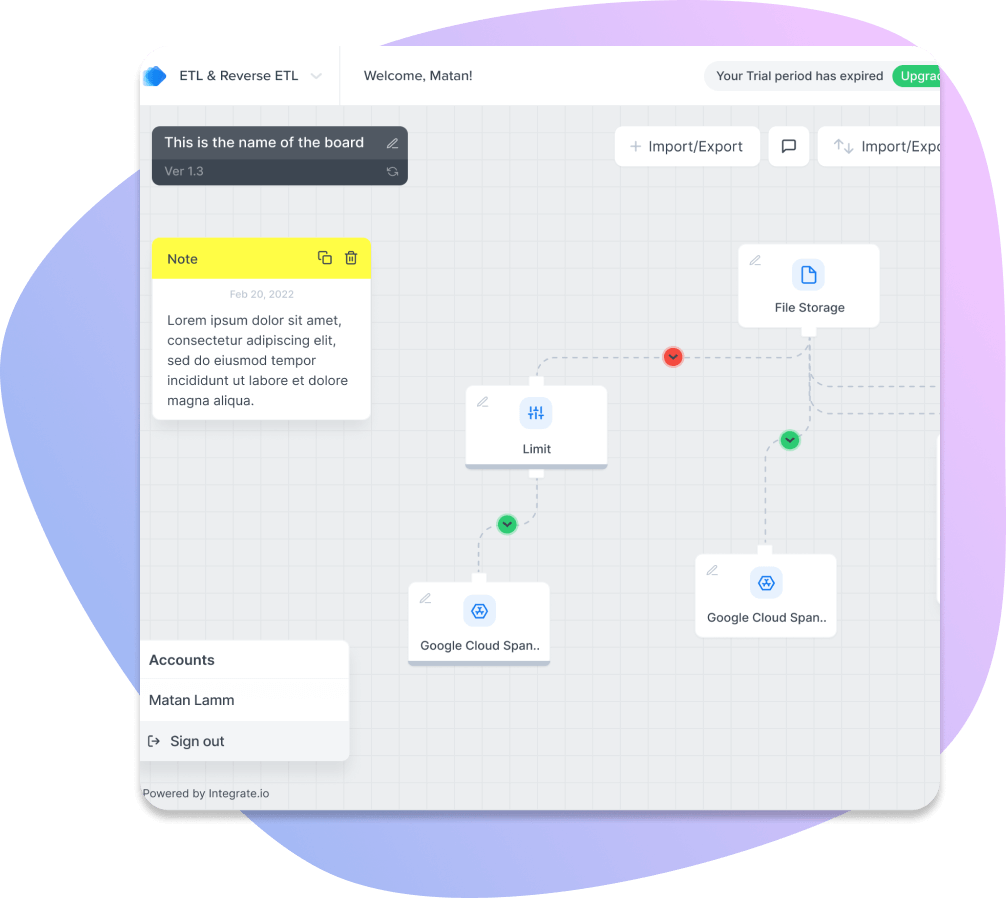

1. Integrate.io

価格:14日間無料トライアル & 柔軟な対応の有料プラン

Integrate.ioは、ETL をシンプルにするデータパイプラインプラットフォームです。複数のソースとデスティネーション間でデータパイプラインを構築するためのシンプルで直感的なビジュアルインターフェースを備え、データ統合のペインポイントを取り除くことができます。また、ELT、リバース ETL、データウェアハウスのインサイト、データ観測、高速CDC(変更データキャプチャ)を実行するプラットフォームであり、あらゆるデータ統合のニーズに応えるワンストップショップとなっています。

その他、Integrate.ioを利用するメリットとして、データエンジニアへの依存度の軽減、データ品質の向上、より正確なデータ変換、GDPR(EU一般データ保護規則)などのガイドラインへの準拠性の向上などが挙げられます。

ETLプロセスでは、Integrate.io がデータベース、アプリSaaSツール、CRM(顧客関係管理)システム、ERP(企業資源計画)システムなどのソースから情報を抽出します。次に、プラットフォームが、データウェアハウスの標準に準拠し、GDPR などのデータガバナンスフレームワークに準拠するようにデータを変換し、最後に、Integrate.io が、分析用の集中型レポジトリにデータを格納します。

Integrate.io の事前構築済みコネクターで、 MongoDB、 MySQL、 PostgreSQL、 Amazon Redshift、Microsoft Azure SQL Database、 Salesforce、Slack、QuickBooksなど、100以上の一般的なデータストアと SaaS アプリケーションが動作しています。

さらに Integrate.io には、スケーラビリティ(拡張性)、安全性、優秀なカスタマーサポートといった利点があります。その上、プラットフォームの Field Level Encryption(フィールドレベル暗号化)は、ユーザーが独自の暗号化キーを使ってデータフィールドを暗号化および復号化することができます。

これらの利点により、Integrate.io は G2 ウェブサイトの 161 名のレビュアーから、5 つ星のうち平均 4.3 の評価を得ています。また、2024年秋のETLツール分野におけるG2の「リーダー」の1つにも選ばれています。ある検証ユーザーは、「Integrate.ioは、私たちのビジネスニーズの大部分に対して簡単に実装できました。ビジネスのデータジョブを複製することができ、Integrateのチームは素晴らしい仕事をしてくれました。」

Integrate.io の主な機能

-

スケーラビリティ:ビジネスのニーズに合わせて拡張することができ、必要に応じて新しいソースやデスティネーションの迅速な追加が可能。

-

安全性:フィールドレベルの暗号化による、統合プロセスを通じたデータの安全性の保証。

-

カスタマーサポート:ユーザーの疑問や問題解決にいつでも対応可能であり、優れたレスポンスタイムのもとで、常にヘルプが待機。

-

コネクタと統合:さまざまなシステムやアプリケーションへのコネクタが200以上提供されており、ビジネスにおいて複数のソースとデスティネーションの間でのデータの迅速な接続が可能。

-

パイプライン内の変換: パイプライン内のデータ変換を管理することができる強力なデータエンジンに対応しており、格納前にデータ変換を行うことで、データウェアハウスを巡回する際の計算コストの削減が可能。それによって、大容量のデータを取り込むための非常に費用対効果の高い機能であることが証明される。

-

高度なモニタリング:高度なモニタリングとロギング機能により、トラブルシューティングの簡素化や統合問題の防止を実現。Integrate.io には、進捗状況を生でモニタリングするための追跡メトリクスがあり、このようなメトリクスが、大量のデータの統合を完了するまでの予測時間を計算し、モニタリングログが、統合に関する問題を深く掘り下げ、トラブルを未然に防ぐ。

-

カスタマイズ: X-console、豊富なEL式、高度な API、Web フックなど、ユーザーが自由にプラットフォームをカスタマイズできるように、さまざまなカスタマイズ機能が提供されている。

-

柔軟性と使いやすさ:ローコードでの変換からマニュアルでのカスタマイズまで、新規ユーザーだけでなく上級ユーザーにも柔軟に対応可能。

- 信頼できる唯一の情報源(Single source of truth):ユーザーが複数のソースからデータを組み合わせて単一のデスティネーションに届けることを可能にする「信頼できる唯一の情報源(Single source of truth)」として機能する。

総合的に、Integrate.io は、最小限の労力で迅速かつ簡単にシステムを統合したいと考えている人にとっては優れた選択肢となることでしょう。強固な機能と比類のないカスタマーサポートによって、Integrate.ioは ETL 業界における重要なプレーヤーとなり、その幅広いデータ変換機能と統合テンプレートは、あらゆる規模のビジネスに最適であり、その競争力のある価格は、予算重視の顧客にとって魅力的な選択肢となります。Integrate.io があれば、迅速かつ正確なデータ統合を確信できるでしょう。

2. Talend

価格:月額:1ユーザーあたり1,170ドル。年額:1ユーザーあたり12,000ドル

Talendは、ETL データ統合ソリューションのスイートを提供しています。Talend のプラットフォームは、オンプレミスおよびクラウドのデータソースと互換性があり、何百もの事前構築済みの統合が含まれています。

Talendのオープンソース版(Talend Open Studio)で十分だと思うユーザーもいるでしょうが、大規模企業は Talend の有料データ統合プラットフォームを好む可能性が高いでしょう。このバージョンのTalendには、デザイン、生産性、管理、モニタリング、BI(ビジネスインテリジェンス)、データガバナンスのためのツールや機能が追加されています。

Talend Data Integrationは、G2において5つ星のうち平均4つの評価を得ており、ウェブサイトでは2022年の冬にこのプラットフォームの迅速な導入が強調されています。レビュアーのJan L.は、Talend Data Integrationは 「データ統合のための素晴らしい万能ツール 」で、「明確で理解しやすいインターフェース である」と言っています。

Talend の主な機能

- 迅速な実装:大規模なデータ構造の迅速かつ正確な実装が可能。

- データ品質:ユーザーは、プロファイリング、クレンジング、重複の最小化などの利用を通じて、データ品質の維持が可能。

- データガバナンス:タグ付け、追跡、モニタリング機能により、ユーザーはデータガバナンスの管理が可能。

- 自動化とスケジューリング:スケジューリング機能でデータ統合プロセスを自動化する機能の提供。

総合的に、Talend はデータ統合プラットフォームをお探しの方にとって、強力で信頼できるソリューションになります。さまざまな機能と性能が備わっているため、大量のデータを効率的に管理・分析し、それによって組織はデータを最大限に活用することができます。

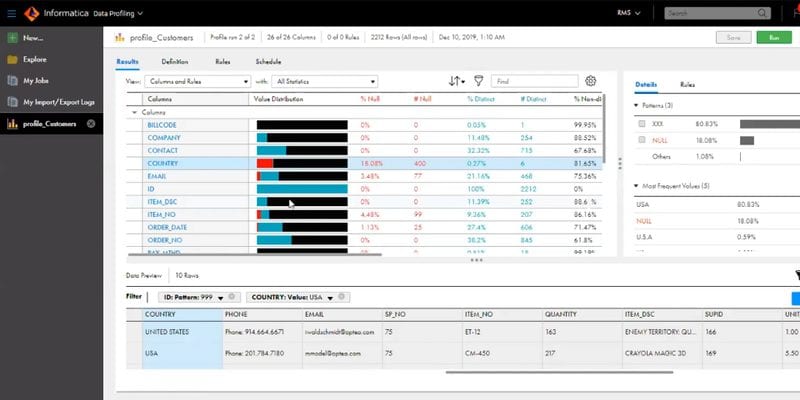

3. Informatica PowerCenter

価格:月額2,000ドルから。無料体験有り。

Informatica PowerCenter は、ETLワークロードのための、成熟した、機能豊富な企業向けデータ統合プラットフォームですが、PowerCenter は、クラウドデータ管理ツールである Informatica スイートのツールのうちの1つのに過ぎません。

エンタープライズ級のデータベースニュートラルな(データベースに依存しない)ソリューションである PowerCenter は、高い性能と、SQLや非SQLデータベースを含むさまざまなデータソースとの互換性で定評があり、構造化および非構造化データをロケーションから移動し、データ統合プロジェクトの改善に使用することができます。

ただ、Informatica PowerCenter の残念な点は、価格の高さと習得の難しさであり、技術力のない小規模な組織では敬遠される可能性があります。Informaticaはウェブサイトで様々なチュートリアルやリソースが提供されていますが、ユーザーは習得が大変かもしれません。

このような欠点があるにもかかわらず、Informatica PowerCenter は、G2の 5つ星のうち平均 4.4 を獲得し、2024年のITインフラ製品のトップ 50に選ばれるほどの支持を得ています。レビュアーのVictor C.氏は、PowerCenterを「私がこれまで使用した中で、おそらく最も強力なETLツール」と評価しています。しかし、PowerCenterは動作が遅く、TableauやQlikViewのようなビジュアライゼーション・ツールとうまく統合できないことも不満に思っています。

Informatica の主な機能:

- データの取り込みと変換の自動化:ETLプロセスを自動化し、それによってソース間のデータ移動がより簡単で迅速になる。

- 強固なセキュリティオプション:暗号化、ユーザーアクセス制御など、さまざまなセキュリティ対策による機密データの保護が可能。

- 高度な分析:予測分析、機械学習アルゴリズムなどを用いて、データセットに対するインサイトが得られる。

- 可視化ツールとの統合:Tableau、QlikViewなど、一般的な可視化との統合が簡単にできる。

- スケーラビリティ:小規模なデータセットから大規模なウェアハウスまで、さまざまなデータに対応。

総合的に、Informatica は、組織の迅速かつ安全なデータ移動に役立つ強力な IT インフラ製品です。初期設定が必要ですが、データ管理、分析機能、セキュリティの向上というメリットは、その努力に十分見合うものでしょう。

4. SAS Data Management

価格:求める機能による

SAS Data Management は、様々なソースと接続し、ETLパイプラインを構築することなく、サポートされたデスティネーションにデータを移動させます。また、RDB(リレーショナルデータベース)、トランザクションデータベース、CRM(顧客関係管理)プラットフォーム、またはその他のソースからのデータを統合したい場合でも、SAS Data Management には必要な ETL 機能が備わっています。

SAS Data Management の最も注目すべき機能の一つに、データ分析のためのソースからウェアハウスへのデータ移動の速さです。 データをウェアハウスに ETL(抽出、変換、格納)し、BI ツールで貴重なレポートやその他のデータ視覚化を生成して、意思決定を改善できます。

このリストを書いている時点では、SAS Data Management は G2 で 星5つ中平均 4.1 のユーザー レビュー スコアになっていますが、その機能にもかかわらず、プラットフォームの価格を指摘しているレビュアーが何人かおり、あるレビュアーは、このツールは「多くの企業や個人にとってはお手頃価格ではないかもしれない」とコメントしています。

SAS Data Management の主な機能

- データ品質:データの正確性、完全性、一貫性を保証

- 高度な分析サポート:BI ツールを使った、貴重なレポートやその他の分析ビジュアルの生成

- 拡張性と柔軟性:柔軟性の高いパラメーターにより、操作の拡張がしやすい

- 自動スケジューリングとアラート:ワークフロー管理改善のための、ジョブのスケジュールと、自動アラートの設定。

総合的に、SAS Data Management は、データの管理を検討している人にとってはいいプラットフォームです。 情報に基づいた意思決定を行うのに必要な機能を全て備えていますが、一部の企業や個人にとっては価格がネックになり、ツールの使用を躊躇してしまう可能性があります。

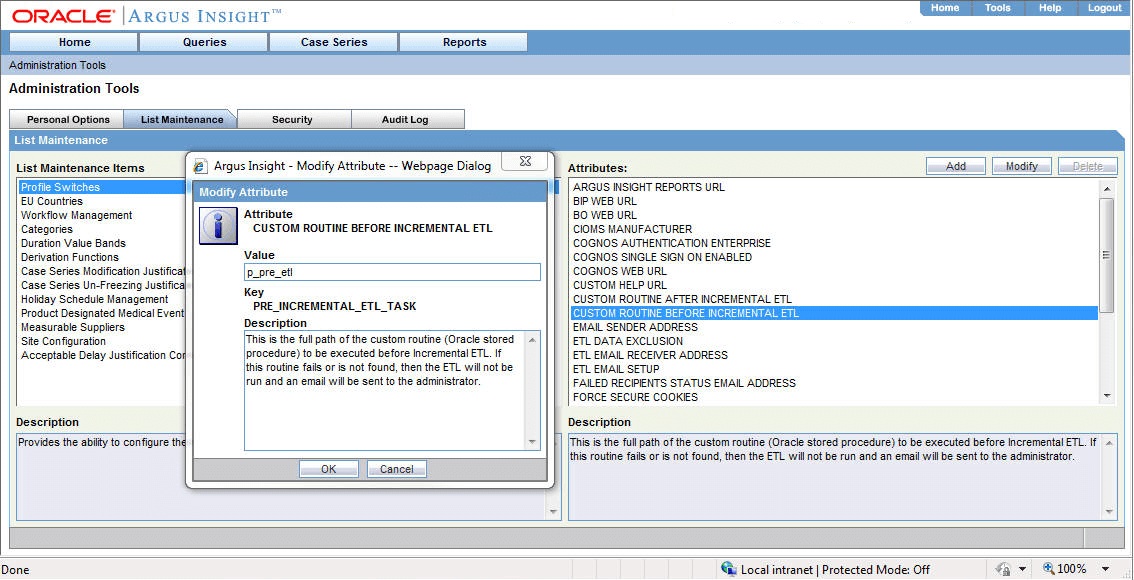

5. Oracle Data Integrator

価格:HP 参照

ODI(Oracle Data Integrator) は、Oracle のデータ管理エコシステムの一部である包括的なデータ統合ソリューションです。 これにより、このプラットフォームは、ハイペイオン財務管理(Hyperion Financial Management )や OracleEBS( E-Business Suite)などの他の Oracle アプリケーションの現ユーザーにとって賢明な選択となります。 因みにODIには、「オンプレミス」と「クラウド」の両方のバージョンがあります(後者の製品はOracle Data Integration Platform Cloudです)。

このリストにある他のほとんどのソフトウェア ツールとは異なり、Oracle Data Integrator はETLの実行はできますが、主に ELTの ワークロードに対応しています。 また、ODI は、この記事で紹介されているの他のほとんどのツールよりも必要最低限しか備わってない機能であり、特定の周辺機能は他の Oracle ソフトウェアに代わりに含まれています。

Oracle Data Integrator は、G2 で 星5つ中 平均 4つの評価を得ています。 G2 のレビュアーである Christopher T. によると、ODI は「多数のオプションを備えた非常に強力なツール」ですが、「習得が難しすぎる」ので「トレーニングが絶対にいる」と言っています。

ODI の主な機能

- 高度なデータ変換機能を搭載

- Hadoop および NoSQL データベースとの接続

- データ統合プロセスの自動化のための強固なスケジューリング エンジン

- ODI プラットフォームクラウドで利用可能なクラウド版

- SQLクエリの作成およびデバッグ用の強固なグラフィカル・インタフェースである SQL Developer が含まれている

総合的に、ODI は多くの機能を備えた強力な ETL ツールであり、 Hadoop や NoSQL データベースと接続する機能および自動化機能により、データ統合プロセスの効率化を検討している企業にとっては魅力的な選択肢となっています。 ただし、ユーザーは、適切なトレーニングと練習なしでは ODI を習得するのが難しい場合があることに注意が必要です。

6. Stitch

価格:月額100ドルから。14日間の無制限お試し有り

Stitch は、オープンソースのELTデータ統合プラットフォームであり、Talendのように、より高度なユースケースや多数のデータソースに対応した有料サービス層も提供しています。StitchとTalendの比較は、色んな意味で適切です:Talendは2018年11月にStitchを買収しました。

Stitch のプラットフォームは、セルフサービスのELTと自動化されたデータパイプラインを提供し、データ統合をよりシンプルにすることで、他とは一線を画しています。ただし、これから利用する人は、Stitch のELTツールは任意の変換を行わないことに注意しないといけません。むしろ、Stitch のチームは、データウェアハウス内にある生データの上に、レイヤーを重ねて変換を追加することを提案していますからね。

G2 ユーザーによる Stitch の評価は概ね良好で、平均評価は星5つ中4.5となっており、2023年冬には「Leader」に選定されています。あるレビュアーは、Stitchの 「シンプルな価格設定、内部構造のオープンソース化、導入のしやすさ 」を好評価していますが、Stitch のレビューの中には、ちょっとした技術的な問題や、あまり一般的ではないデータソースのサポート不足を挙げるものもあります。

Stitchの主な機能

- リアルタイムアラートによる、正確で一貫性のあるデータフローの実現

- ELTプロセスの自動化による、インサイトまでの時間の短縮

- サポートチームの可視化のための高度なモニタリング&トラブルシューティングツール

- 品質保証のためのデータプレビュー機能

- 自動スケーラビリティによる、データプラットフォームの高い可用性の保証

総合的に、Stitchは、使いやすく信頼性の高いデータプラットフォームを必要とする企業にとって最適な選択肢ですが、どのようなデータプラットフォームでも、技術的な問題や、あまり一般的ではないデータソースのサポートがない場合があることに留意しておくことが重要です。なので、どのようなプラットフォームであっても、チームに導入する前に十分な調査を行うようにすれば、ニーズを全て満たすデータプラットフォームを選べるでしょう。 Stitch は素晴らしい選択肢ですが、他のサービスやプラットフォームとの互換性も確認しましょう。

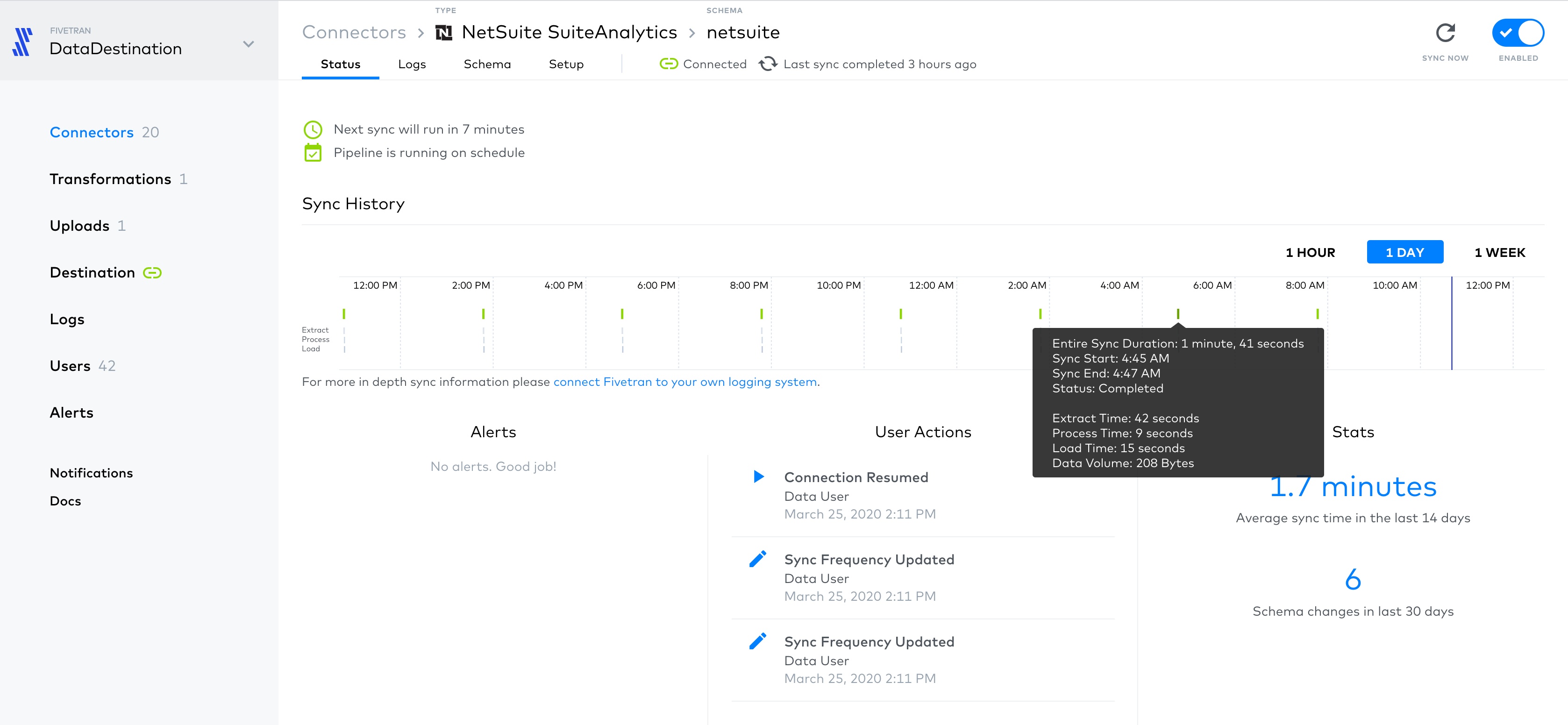

7. Fivetran

価格:価格は月間アクティブ行数に基づいており、利用率曲線はこちらで詳しく説明しています。 データソースにもよりますが、MARは約500k~1M MAR / GBでGBに換算できます。

Fivetran は、Redshift、BigQuery、Azure、Snowflakeのデータウェアハウスとのデータ統合をサポートするクラウド型 ETL ソリューションであり、Fivetran の最大のメリットとして、複数のSaaSソースを利用でき、独自のカスタム統合を追加できるなど、豊富なデータソースが用意されている点があります。

Fivetran は現在、G2において星5つのうち4.2を獲得しており、多くのユーザーがこのプラットフォームのシンプルさと使いやすさを賞賛しています。また、G2はこのETLツールを2024年冬の「Leader」に選定しており、レビュアーの Daniel H.は、「Fivetranについて時間をかけて考える必要はないということは、Fivetranが こちらの要望に答えてくれているという素晴らしい兆候ですよね。しっかりとしたドキュメントがあるので、新しいコネクタのフックアップは大体サッと簡単にできます。」とコメントしています。

ただ、G2のレビュアーの中には、Fivetranの消費型価格モデルに不満を持っている人もいます。(このプラットフォームは、以前はコネクタの使用数に応じて課金していたため、特定のデータ統合のユースケースにおいては、その方が安くつくこともある)。さらに、「Fivetran はブラックボックスで、問題発生時の診断が本当に難しいし、サポートラインも大したことはありません。」という、技術的な問題やカスタマーサポートに問題を抱いているユーザーも少数ながら存在します。

Fivetran の主な機能

- データセキュリティとプライバシー管理

- 自動化されたデータ変換機能

- リアルタイムの分析機能

- ロギングとレポート機能

総合的に、Fivetranはデータ統合プロセスの効率化を目指す企業にとって、素晴らしい ETL ソリューションであり、このプラットフォームによって、あらゆる規模の組織が、複数のソースからのデータ移動や、分析に適した形への変換を、迅速かつコスト効率よくしやすくなります。Fivetran の顧客サービスや価格モデルには多少の問題が報告されていますが、同社は強固なセキュリティとプライバシー管理、自動データ変換機能、リアルタイム分析機能、ロギング/レポーティングツールを提供しています。このような特徴を持つFivetranは、データ統合プロセスの改善を目指す企業にとって、最適な選択肢となり得るでしょう。

さらに検討すべきETLツール7選

上記の7つのソリューションは、Integrate.io が個人的に推奨するトップ ETLツールですが、他にも検討すべきオプションはたくさんあります。以下では、2023年に技術スタックに追加したいETLツールを7つご紹介します。

8. Striim

Striimは、ビッグデータのワークロードのためのリアルタイムデータ統合プラットフォームを提供しており、ユーザーは、Oracle、SQL Server、MySQL、PostgreSQL、MongoDB、Hadoopなど、さまざまなデータソースとターゲットをさまざまなファイル形式で統合することができます。また、Striimは、GDPR(EU 一般データ保護規則)やHIPAA(医療保険の携行性 と責任に関する法律)などのデータプライバシー規制に準拠しており、ユーザーはSQLやJavaを使ってプリロード変換を確定することができます。

ただ、Striim のプラットフォームには、SaaS(サービスとしてのソフトウェア)のソースやターゲットが含まれておらず、ユーザーは新しいデータソースを追加することができないなど、欠点がいくつかあります。また、Striim のユーザーベースはかなり小さいようで、G2にはレビューが1件あるだけです。

9. Matillion

Matillion は、Redshift、Snowflake、BigQuery、Azure Synapseとデータを統合できるクラウドETLプラットフォームであり、ユーザーは、シンプルなポイント&クリックのインターフェース、またはSQLで確定することによって、Matillionでデータ変換を作成することができます。

ただ残念ながら、Matillion は Striimと同様の欠点を抱えています。Matillionの可能なSaaSソースの数は、このリストの他の選択肢と比べて不足しており、G2(Matillionは星5つのうち4.4)のレビュアーは、「ジョブやコンピューティングリソースの使用量ではなく、仮想マシンを起動した時間に基づいて課金されることから、使用量が多くないユーザーには価格モデルが難しい。」とコメントしています。

10. Pentaho

Pentaho(別名:Kettle)は、日立バンタラが提供するオープンソースのプラットフォームで、データ統合や分析に利用されており、ユーザーは、Pentahoの無料コミュニティ版か、エンタープライズ版の商用ライセンスを購入することができます。Integrate.ioと同様に、Pentaho はユーザーに優しいインターフェースを備えており、ETL 初心者でも強固なデータパイプラインを構築できるようになっています。

ただ Pentaho には、限られたテンプレートセットや技術的な問題など、独自の欠点があります。現在G2では星5つのうち平均4.3の評価を得ており、ユーザーの中には、「ログ画面にエラーの詳細な説明がないため、エラーの原因がわからないことがある。」 など、問題に遭遇したことを訴えるユーザーもいます。

11. AWS Glue

AWS Glueは、ビッグデータおよび分析ワークロードを対象とした AWS(Amazon Web Services)のフルマネージド ETL サービスです。AWS Glueは、フルマネージドでエンドツーエンドのETLサービスとして、ETLワークロードの苦痛を軽減するようにデザインされており、AWSエコシステムの他の部分とうまく統合されています。

特筆すべきは、AWS Glue がサーバーレスであることで、つまり、Amazonがユーザー向けにサーバーを自動的に用意し、ワークロードが完了するとシャットダウンするという点です。また、AWS Glueには、ジョブスケジューリングやAWS Glueスクリプトをテストするための「デベロッパーのエンドポイント」などの機能があり、ツールがより使いやすくなります。

AWS Glue のユーザーからは、おおむね高い評価を得ています。現在、G2では星5つのうち4.2を獲得しており、2023年冬の ETL ツールの分野では「Leader」に選ばれています。ただAWS Glueは、他のプラットフォームよりも柔軟性が低く、通常は AWSエコシステム内のユーザーに最も適しているため、Integrate.io のベストETLツール7選のリストには含まれていません。

12. Panoply

Panoplyは、データ統合プロセスの簡素化を目的とした、自動化されたセルフサービス型クラウドデータウェアハウスであり、標準的な ODBC/JDBC 接続、Postgres 接続、AWS Redshift 接続があるデータコネクタであれば、Panoplyと互換性があります。さらに、ユーザーは Panoply を Stitch や Fivetran などの他の ETLツールと接続し、データ統合ワークフローをさらに強化することができます。

G2において、Panoply は星5つのうち平均4.5を獲得しており、レビュアーの Stacie B.氏は、「Panoplyの一番いいところは、複数のソースからのデータのインポートが簡単なところです。ちなみに、プログラムのセットアップとデータの読み込みは10分もかかりませんでした。」とコメントしています。

では、なぜ Panoply は Integrate.io のトップETLツール7選のリストに入らなかったのでしょうか。Panoply には、データウェアハウスとETLソリューションの両方の機能を提供しようとしているという大きな問題があるからです。すでに別のクラウドデータウェアハウスを使用していて、変化を求めていないのであれば、Panoply は要りませんもんね。

13. Alooma

Aloomaは、クラウド上のデータウェアハウスのためのETLデータ移行ツールであり、データパイプラインの多くを自動化することで、技術的な詳細ではなく、よりデータ分析に集中できるようにする点が、主なセールスポイントです。

2019年2月、Google は Alooma を買収し、今後のサインアップをGoogle Cloud Platform のユーザーに制限しました。つまり、Redshift や Snowflake などの他のデータウェアハウスを使っている顧客は、代替ソリューションを探し続ける必要があるということです。

とはいえ、Aloomaはユーザーから概ね好意的な評価を得ており、G2では星5つのうち4.1を獲得しています。あるユーザーは、「Aloomaのコードエンジン機能による柔軟性がいいです...(ただし)社内ツールスタックの鍵となる入力の部分は、いくつかはあまり成熟していないですね 」とコメントしています。

14. Hevo Data

Hevo Dataは、データベース、クラウドストレージ、SaaSソースへの100以上の事前構築済コネクタを備えたETLデータ統合プラットフォームであり、ユーザーは、Python を使ってHevo Dataで独自のプリロード変換を確定することができます。また、Hevo Dataは、Redshift、BigQuery、Snowflakeなど、最も一般的なデータウェアハウス先に対応しています。

Hevo の最大の制約の一つに、独自のデータソースを追加できない点があります。なので新しい接続が必要な場合、あなたの機能リクエストがHevoの開発者の耳に届くように手を合わせておくことしかできません。とはいえ、Hevo DataはG2において大体ポジティブな評価を得ており、平均ユーザースコアは星5つのうち4.4となっています。

トップETLツールのユースケース

ETLソフトウェアツールは2つとして同じものはなく、それぞれに利点と欠点があります。ビジネスのユースケースに最適なETLツールを見つけるには、要件、目標、優先順位の正直な評価が必要でしょう。

以上の比較から、それぞれのETLツールに興味を持つであろうユーザーのタイプを以下のリストに示しました:

-

Integrate.io:ETLおよび/またはELTワークロードを使う企業、技術者でなくても使える直感的なドラッグ&ドロップインターフェースを好む企業、多くの事前構築済み統合を必要とする企業、データセキュリティを重視する企業、GDPRやその他のデータガバナンスフレームワークに準拠したい企業など。

-

Talend:オープンソースのソリューションを好む企業(Talend Open Studio)、事前構築された統合と追加機能を多数必要とする企業(Talend Data Integration)。

-

Informatica PowerCenter:大きな予算と要求性能の高いものがある大規模企業。

-

SAS Data Management:データ分析のために異なる拠点間でのデータ移動に高速性を求める大規模企業。

-

Oracle Data Integrator:既存のオラクルの顧客で、ELTワークロードが使われている企業。

-

Stitch:オープンソースのソリューションを好む企業、シンプルなELTプロセスを好む企業、複雑な変換を必要としない企業。

- Fivetran:多くの事前構築された統合を必要とする企業、複数のデータウェアハウスの柔軟性を必要とする企業。

Integrate.ioは、以下のツールを最高のETLソリューションとしてオススメすることはできませんが、特定のユースケースには適しているかもしれません:

-

Striim:GDPR や HIPAA への準拠が必要な企業、新しいデータソースの追加が不要な企業(特にSaaS)

-

Matillion:シンプルなポイント&クリックのインターフェースを使いたい企業、限られた数のデータソースしかない企業

-

Pentaho:オープンソースのETLツールを好む企業

-

AWS Glue:AWSの既存顧客で、フルマネージドETLソリューションを必要とする企業。

-

Panoply:ETLとデータウェアハウスを組み合わせたソリューションを希望する企業。

-

Alooma:Google Cloud Platformの既存顧客

- Hevo Data:Pythonを使って独自のデータ変換を追加したい企業、新しいデータソースの追加が不要な企業。

Integrate.ioがETLにできること

Integrate.ioは、以下のような特徴を備えていることから、最も優れたETLツールの1つになります:

- CRMシステム、SaaSツール、データウェアハウス、データレイク、その他のソースやデスティネーションのための、事前構築済みのネイティブデータコネクタ

- 高速データ変換

- GDPRをはじめとするデータガバナンスの枠組みへの対応

- ELT、ReverseETL、CDC、データウェアハウスインサイト、データ観測など、従来のETL以外のデータ統合ソリューション

- 世界規模の顧客サービス

- 独自のデータコネクタの構築

Integrate.ioは、限られたスキルセットしか必要としないことから習得が難しくなく、あらゆる規模の組織がデータを抽出、変換、格納することができるため、拠点間のデータ移動に最適な方法です。

以下は Integrate.io にお任せください:

- データソースからのデータを抽出および、ステージングエリアへの配置

- データウェアハウスのようなデスティネーションに適した形式へのデータ変換。変換段階には、不正確なデータのチェック、重複するデータセットの削除、データ統合が関連する業界標準やGDPRなどの法律に準拠していることの確認などが含まれる場合がある。

- (通常は分析のために)集中管理されたターゲットシステムへのにデータの格納。この段階で、Tableau、Looker、MicrosoftなどのBI(ビジネスインテリジェンス)ツールでデータセットを実行し、より良い意思決定のための強力なインサイトの生成が可能。

2つの拠点間でデータを移動させるIntegrate.ioのユースケースをご紹介します:

Salesforceのデータを分析し、最も価値のある顧客を見つけたいとします。Integrate.io のネイティブSalesforceコネクタが、CRMシステムからデータを抽出し、データ分析に適した形式に変換して、Amazon Redshiftなどのデータウェアハウスに格納します。ちなみにこのプロセスでは手作業はほとんど必要なく、Salesforceのデータからより多くの価値を得られます。

Integrate.ioは、データのETLを面倒な作業から解放する、ノーコードのデータパイプラインプラットフォームです。今やデータ統合の課題に対処することなく、対応している場所にデータをETLできるようになりました。ぜひ今すぐデモをご予約ください。